Μεγαλύτερη απειλή από τα πυρηνικά; «Ρομπότ-δολοφόνοι»: Διχάζουν την κοινή γνώμη, ενώνουν την τεχνολογική κοινότητα

Πώς τα αυτόνομα όπλα θα μπορούσαν να είναι πιο αποσταθεροποιητικά από τα πυρηνικά-Η ανάπτυξη θανατηφόρων αυτόνομων όπλων είναι ανήθικη και θα πρέπει να απαγορευθεί σε διεθνές επίπεδο

Φανταστείτε έναν κόσμο στον οποίο στρατιωτικοί, αντάρτικες ομάδες και διεθνείς και εγχώριοι τρομοκράτες, μπορούν να αναπτύξουν θεωρητικά απεριόριστη θανατηφόρα δύναμη με θεωρητικά μηδενικό κίνδυνο σε στιγμές και μέρη της επιλογής τους, χωρίς καμία ευθύνη.

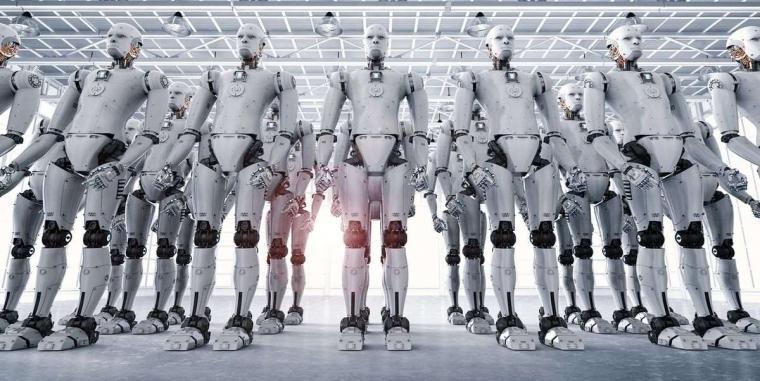

Τα αυτόνομα οπλικά συστήματα, είναι ρομπότ με θανατηφόρα όπλα που μπορούν να λειτουργήσουν ανεξάρτητα, επιλέγοντας επιτιθέμενους στόχους, χωρίς άνθρωπο να σταθμίζει αυτές τις αποφάσεις. Οι στρατιωτικοί σε όλο τον κόσμο, επενδύουν σε μεγάλο βαθμό στην έρευνα και ανάπτυξη αυτόνομων όπλων. Μόνο οι ΗΠΑ είχαν προϋπολογισμό 18 δισεκατομμύρια δολάρια, για αυτόνομα όπλα μεταξύ 2016 και 2020.

Σε μήλον της έριδος έχουν μετατραπεί τον τελευταίο καιρό τα αυτόνομα πολεμικά όπλα, γνωστά με την επωνυμία «ρομπότ δολοφόνοι», με τους ιδρυτές 116 εταιρειών ρομποτικής και τεχνητής νοημοσύνης να ζητούν άμεσα την απαγόρευση της χρήσης τους, μετά και την αναβολή των συνομιλιών του ΟΗΕ, για τη ρύθμιση της χρήσης των θανατηφόρων αυτόνομων οπλικών συστημάτων που βασίζονται στην τεχνητή νοημοσύνη.

Τα αυτόνομα όπλα απειλούν να βιομηχανοποιήσουν τον πόλεμο αλλά και τον τρόπο, με τον οποίο σκοτώνουμε τους ανθρώπους. Αν γίνουν μέρος του στρατιωτικού βιομηχανικού συμπλέγματος ,είναι σίγουρο πως θα καταλήξουν να χρησιμοποιούνται εναντίον αμάχων.

Εν τω μεταξύ, οι ανθρωπιστικές οργανώσεις, αγωνίζονται να θεσπίσουν κανονισμούς και απαγορεύσεις για την ανάπτυξη αυτών των όπλων. Χωρίς τέτοιους ελέγχους, ειδικοί της εξωτερικής πολιτικής προειδοποιούν ότι οι διαταρακτικές τεχνολογίες αυτόνομων όπλων, θα αποσταθεροποιήσουν επικίνδυνα τις τρέχουσες πυρηνικές στρατηγικές, τόσο επειδή θα μπορούσαν να αλλάξουν ριζικά τις αντιλήψεις για τη στρατηγική κυριαρχία, αυξάνοντας τον κίνδυνο προληπτικών επιθέσεων όσο και επειδή θα μπορούσαν να συνδυαστούν με χημικά, βιολογικά και ακόμα τα ίδια τα πυρηνικά όπλα.

123 κράτη-μέλη της διάσκεψης του ΟΗΕ για την Σύμβαση για τα συμβατικά όπλα, συμφώνησαν να ξεκινήσουν οι επίσημες συζητήσεις και για τα αυτόνομα όπλα. Από αυτούς, 19 έχουν ήδη ζητήσει την οριστική τους απαγόρευση.

Μεταξύ των κρατών που σπεύδουν να αναπτύξουν αυτή την αυτόνομη τεχνολογία όπλων, η οποία έχει τη δυνατότητα να επιλέγει ανεξάρτητα συγκεκριμένα πλάνα δράσης χωρίς να βασίζεται στην κρίση ενός ανθρώπινου ελεγκτή, συγκαταλέγονται οι ΗΠΑ, η Κίνα και το Ισραήλ.

Η πρόοδος της τεχνητής νοημοσύνης καθιστά δυνατή την μεταβίβαση πολλών εργασιών , οι οποίες μέχρι πρότινος, θεωρούνταν αδύνατο να εκτελεστούν από μηχανές, δυνατή, ακόμα και αυτή ενός σύγχρονου πολέμου.

Θανατηφόρα όπλα και μαύρα κουτιά – το πρόβλημα της εσφαλμένης αναγνώρισης

Κατά την επιλογή ενός στόχου, τα αυτόνομα όπλα θα μπορούν να κάνουν διάκριση μεταξύ εχθρικών στρατιωτών και παιδιών 12 ετών που παίζουν με όπλα-παιχνίδια; Μεταξύ αμάχων που φεύγουν από ένα σημείο σύγκρουσης και ανταρτών που κάνουν τακτική οπισθοχώρηση;

Το πρόβλημα εδώ, δεν είναι ότι οι μηχανές θα κάνουν τέτοια λάθη και οι άνθρωποι όχι. Είναι ότι η διαφορά μεταξύ ανθρώπινου σφάλματος και αλγοριθμικού σφάλματος, είναι σαν τη διαφορά μεταξύ αποστολής μιας επιστολής και ενός tweeting. Η κλίμακα, το εύρος και η ταχύτητα των συστημάτων ρομπότ δολοφόνων – που διέπονται από έναν αλγόριθμο στόχευσης, που αναπτύσσεται σε ολόκληρη την ήπειρο – θα μπορούσε να κάνει λανθασμένες ταυτοποιήσεις από μεμονωμένους ανθρώπους, όπως μια πρόσφατη αμερικανική επίθεση με μη επανδρωμένο αεροσκάφος στο Αφγανιστάν, σαν απλή στρογγυλοποίηση σφαλμάτων σε σύγκριση.

Το πρόβλημα δεν είναι μόνο ότι όταν τα συστήματα AI κάνουν λάθος, κάνουν λάθος μαζικά. Είναι ότι όταν κάνουν λάθος, οι κατασκευαστές τους συχνά δεν ξέρουν γιατί το έκαναν και, ως εκ τούτου, πώς να τα διορθώσουν. Το πρόβλημα του μαύρου κουτιού της τεχνητής νοημοσύνης, καθιστά σχεδόν αδύνατο να φανταστούμε ηθικά υπεύθυνη ανάπτυξη αυτόνομων οπλικών συστημάτων.

Τα προβλήματα διάδοσης

Οι επόμενοι δύο κίνδυνοι, είναι τα προβλήματα της διάδοσης χαμηλού και υψηλού επιπέδου. Οι στρατιωτικοί που αναπτύσσουν αυτόνομα όπλα, προχωρούν με την υπόθεση ότι θα είναι σε θέση να περιορίσουν και να ελέγξουν τη χρήση αυτόνομων όπλων. Αλλά αν η ιστορία της τεχνολογίας όπλων έχει διδάξει στον κόσμο κάτι, είναι αυτό: Τα όπλα εξαπλώθηκαν.

Οι πιέσεις της αγοράς θα μπορούσαν να οδηγήσουν στη δημιουργία και την ευρεία πώληση, αυτού που μπορεί να θεωρηθεί ως αυτόνομο όπλο του όπλου Καλάσνικοφ ρομπότ δολοφόνων που είναι φθηνά, αποτελεσματικά και σχεδόν αδύνατο να συγκρατηθούν, καθώς κυκλοφορούν σε όλο τον κόσμο. Τα αυτόνομα όπλα «Καλάσνικοφ», θα μπορούσαν να μπουν στα χέρια ανθρώπων εκτός κυβερνητικού ελέγχου, συμπεριλαμβανομένων διεθνών και εγχώριων τρομοκρατών.

Ωστόσο, η εξάπλωση υψηλού επιπέδου είναι εξίσου κακή. Τα έθνη θα μπορούσαν να ανταγωνιστούν για την ανάπτυξη ολοένα και πιο καταστροφικών εκδόσεων αυτόνομων όπλων, συμπεριλαμβανομένων εκείνων που μπορούν να τοποθετήσουν χημικά, βιολογικά, ραδιολογικά και πυρηνικά όπλα. Οι ηθικοί κίνδυνοι, από την κλιμάκωση της θνησιμότητας των όπλων θα ενισχυθούν με την κλιμάκωση της χρήσης όπλων.

Τα αυτόνομα όπλα υψηλού επιπέδου, είναι πιθανό να οδηγήσουν σε συχνότερους πολέμους, διότι θα μειώσουν δύο από τις κύριες δυνάμεις που ιστορικά έχουν αποτρέψει και συντομεύσει τους πολέμους: ανησυχία για αμάχους στο εξωτερικό και ανησυχία για τους ίδιους τους στρατιώτες.

Τέλος, τα αυτόνομα όπλα θα υπονομεύσουν την τελική στάση της ανθρωπότητας, ενάντια στα εγκλήματα και τις θηριωδίες πολέμου – τους διεθνείς πολέμους.

Αυτοί οι νόμοι, κωδικοποιημένοι σε συνθήκες που φτάνουν μέχρι τη Σύμβαση της Γενεύης του 1864 , είναι η διεθνής λεπτή μπλε γραμμή που χωρίζει τον πόλεμο με τιμή από τη σφαγή. Βασίζονται στην ιδέα, ότι οι άνθρωποι μπορούν να λογοδοτήσουν για τις πράξεις τους, ακόμη και κατά τη διάρκεια του πολέμου, ότι το δικαίωμα να σκοτώνουν άλλους στρατιώτες κατά τη διάρκεια των μαχών δεν δίνει το δικαίωμα να δολοφονήσουν πολίτες.

Πώς όμως μπορούν να λογοδοτήσουν τα αυτόνομα όπλα; Ποιος φταίει για ένα ρομπότ που διαπράττει εγκλήματα πολέμου; Ποιος θα δικαστεί; Το όπλο; Ο στρατιώτης? Οι διοικητές του στρατιώτη; Η εταιρεία που έφτιαξε το όπλο; Μη κυβερνητικές οργανώσεις και ειδικοί στο διεθνές δίκαιο, ανησυχούν ότι τα αυτόνομα όπλα θα οδηγήσουν σε ένα σοβαρό κενό λογοδοσίας.

Η νομική και ηθική πρόκληση, δεν διευκολύνεται μετατοπίζοντας την ευθύνη στην αλυσίδα εντολών ή πίσω στον τόπο παραγωγής. Σε έναν κόσμο χωρίς κανονισμούς που επιβάλλουν ουσιαστικό ανθρώπινο έλεγχο των αυτόνομων όπλων, θα υπάρξουν εγκλήματα πολέμου χωρίς εγκληματίες πολέμου για να λογοδοτήσουν. Η δομή των νόμων του πολέμου, μαζί με την αποτρεπτική τους αξία, θα αποδυναμωθεί σημαντικά.

Ο κόσμος δεν πρέπει να επαναλάβει, τα καταστροφικά λάθη της κούρσας των πυρηνικών όπλων.